米Appleは6月5日(現地時間)、年次開発者会議WWDC 2023の基調講演を開催した。米Googleや米Microsoftの今年の開発者会議はAI一色と言っていいものだったが、WWDCは「One more thing」として発表されたMRヘッドセット「Apple Vision Pro」に注目が集まり、AIについての大きな発表はなかった。本稿では、そんな中、「AI」という言葉を使わずにさりげなく発表されたAI関連の新機能をまとめてみた。

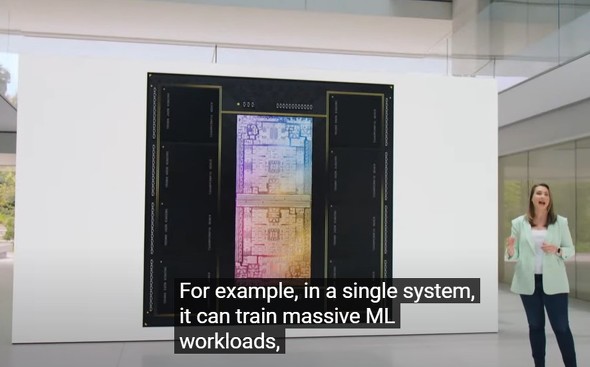

32コアの「Neural Engine」搭載の「M2 Ultra」

新型Mac StudioとMac Proと同時に発表されたプロセッサ「M2 Ultra」は、24個のCPU、76個のGPU、32個の「Neural Engine」を備え、先代の「M1 Ultra」よりCPU性能は最大20%、GPU性能は30%、Neural Engineは40%向上するという。

これは専用のGPUなしでLLM(大規模言語モデル)のトレーニングと実行に十分な性能だとAppleは語った。

iOS 17の留守電文字起こし機能「Live Voicemail」

次期iPhone向けOSとして発表された「iOS 17」にも多数のAI採用機能が追加される。「Live Voicemail」は、誰かからの電話に出られない時、ボイスメールをリアルタイムで文字起こししたり、相手がメッセージを残している間に応答できる機能。

iOS 17の「自動修正」と「音声入力」の機械学習言語モデルによる強化

入力した単語の誤入力を自動的に修正する「自動修正機能」と音声によるテキスト入力「音声入力」は、iOS 17で「単語予測のための最先端のオンデバイス機械学習言語モデルであるtransfomerを備えた包括的なアップデート」を行うという。

iOS 17の「Journal」

「Journal」は、オンデバイスの機械学習を使って日記の入力をサポートする新機能。カレンダーや写真、ワークアウトなどのデータに基づいて日記に書くことを提案する。

iOS 17の「写真」で犬と猫の区別が可能に

「写真」アプリが、人間だけでなく、犬や猫の写真を認識するようになる。

iPadOS 17の機械学習採用の壁紙選択

iPadOS 17の紹介で、クレイグ氏は壁紙のカスタマイズに「高度な機械学習モデル」を使っていると語った。

iPadOS 17の機械学習採用のPDF内フィールド検知機能

「新しい機械学習モデルにより、iPadOSはPDF内のフィールドを識別できるようになった」。

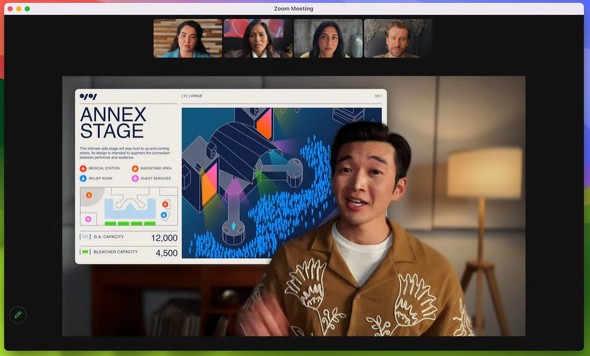

MacOS SonomaのWeb会議にAR機能

MacOS Sonomaの発表では、Web会議の機能として、共有中のコンテンツに重ねてユーザーを表示する「プレゼンターオーバーレイ」やARエフェクトを追加する機能が紹介された。これらは「FaceTime」だけでなく、「Zoom」「Microsoft Teams」「Webex」でも利用できるようになる。

AirPodsの新機能も「機械学習」搭載

AirPodsにもAdaptive Audio、Personalized Volume、Conversation Awarenessなどの新機能が追加される。Appleは、これらの新機能がいずれも「機械学習」を採用していると説明した。

Apple Vision ProのFaceTimeで使える「Persona」

Apple Vision Proでは、FaceTimeでのWeb会議でヘッドセットを装着した本人の代わりにそのユーザーの顔と手の動きをリアルタイムで反映する「Persona」を使えるようになる。AppleはPersonaを「最先端の機械学習技術を使って作成される自分自身のデジタル表現」と定義する。

ユーザーはVision Proの内蔵カメラで自分の顔をスキャンすることで自分のPersonaを生成できる。

筆者が聞き取れた範囲では、WWDCでは機械学習というワードは使ってもAIや生成AIというワードはほとんど使われなかった。

関連記事

関連リンク

からの記事と詳細 ( AI一色にはならなかったWWDCでAppleが発表したAI関連まとめ - ITmedia NEWS )

https://ift.tt/quSfeBE

No comments:

Post a Comment