今、日本国内のスーパーコンピュータ事業が熱い。スパコンの性能を競う世界ランキング「TOP500」で1位(2020年11月時点)を獲った「富岳」や、省電力ランキング「Green500」で1位(20年6月時点)の「MN-3」はいずれも日本の製品だ。こうしたスパコンは大規模な物理演算などに使われるため、基本的には研究機関などが大きなプロジェクトで利用することになる。

こう聞くと、多くの研究者やプログラマーにとっては縁遠いものと考えがちだが、最近は状況が変わってきた。スパコンの老舗メーカーであるNECが、並列計算を得意とするスパコン「SX-Aurora TSUBASA」のプロセッサ「Vector Engine」(ベクトルエンジン、VE)の単体販売を21年1月に始めたのだ。

NECの最新ベクトルプロセッサ「SX-Aurora TSUBASA Vector Engine」

NECの最新ベクトルプロセッサ「SX-Aurora TSUBASA Vector Engine」デスクトップサイズのタワー型サーバにVEを収めた小型モデルも18年から販売しているが、VE単体では価格が114万4000円(税別)とさらに低廉化。「100万円スパコン」と見出しにつけた報道もあり、注目を集めている。

NECのSXシリーズはJAMSTEC(国立研究開発法人海洋研究開発機構)が運用するスパコン「地球シミュレータ」にも代々採用されており、21年3月に運用を始める次世代モデルはVEを5,472台搭載する予定だ。そんなVEを、大学の1研究室や中小企業が保有して自由に使える時代が来ている。

しかし、こんな疑問もあるかもしれない。「これまでの計算環境と違うと、プログラムの移植にも手間がかかって使いこなしが難しいのではないか」──。

すでにGPUからVEにAI処理を移行した、対話AIベンチャー ウェルヴィルの樽井俊行CTOはこう話す。「コードを修正することなくそのまま動き、計算も高速化できました」

VEの使い勝手や有力な応用先について、樽井CTOに話を聞いた。

SX-Aurora TSUBASAに替えるだけで強化学習を高速化 コードの変更は一切なし

ウェルヴィルは2018年に創業したAIベンチャー。樽井CTOは前職で基幹業務システム向けのソフトウェアの開発に長く携わっており、中でも自然言語処理を2010年ごろから担当していた。

ウェルヴィルの樽井俊行CTO

ウェルヴィルの樽井俊行CTO創業以来、対話エンジンを主力製品としてパートナーと研究開発を進めている。特に東京大学医学部との連携が密で、工学系研究科と医学系研究科で教授を務める鄭(てい)雄一氏を顧問に迎え、自由な対話を可能にするエンジンを開発している。そのため、会社も東大医学部の研究棟内にある。

樽井CTOがSX-Aurora TSUBASA(VEを1基搭載するエッジモデル)の応用先に選んだのは、コンテナへの荷物積み込みの最適化と、自由対話エンジンの計算全般だ。

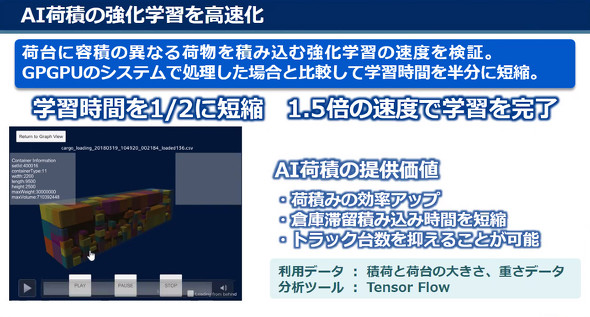

コンテナへの積み込みは深層強化学習(Deep Q Network)を使い、重い荷物を下に、軽い荷物を上に配置しながらできるだけ隙間なく荷物を詰め込むよう学習するプログラムをPythonで実装していた。重めのAI処理であることから、これをまずベンチマークに選んだと樽井CTOは話す。

従来は法人向けGPUで計算を実行していたが、ハードウェアをSX-Aurora TSUBASAに変更。その結果、約1.5倍高速に計算を完了できた。

「もともとの計算自体が数時間という単位でかかるものなので、1.5倍は相当な時間短縮になります」(樽井CTO)

荷物の積み込み最適化にSX-Aurora TSUBASAを利用したら学習速度が1.5倍に

荷物の積み込み最適化にSX-Aurora TSUBASAを利用したら学習速度が1.5倍に移植の際、プログラムのコードは一切変更しなかった。プログラムでは機械学習フレームワークの「TensorFlow」を利用していたが、NECがSX-Aurora TSUBASAでもこれらを使える環境を用意。

(参考:https://github.com/sx-aurora-dev/tensorflow)

もともとNECのSXシリーズはSX-Aurora TSUBASA世代になってからLinux OS上での運用が可能になったため、GPUなどを使う従来の開発環境とは互換性が高い。こうした背景が、プログラムの修正なしの移植を可能としている。

「GPUを使う際とは違う何かをする必要は全くありませんでした。例えば機械学習の入門書通りにプログラムを書いたとしても、そのままで動くと思います」(同)

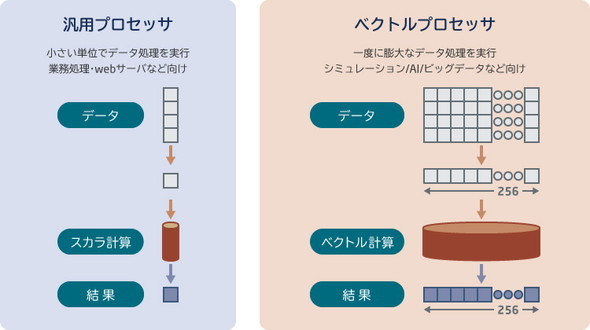

ベクトルエンジンはなぜ速い?

GPUもVEも、並列計算が得意な演算ユニットではある。GPUは画像処理の文脈から、今になっては一般的な並列計算にも利用されるようになっているが、VEは大規模な流体計算や気象の計算といった並列計算に以前から使われてきた。

ベクトルエンジン自体も「ベクトル型」という命令方式で、複数の演算を一度に行えるよう作られている。メモリ帯域幅が大きいのも特長だ。最大1.53TB/sというスペックはPCIeボードサイズの他社の現行のフラグシップアクセラレータと比べても高速で、「世界トップクラスのアクセス性能」(NEC)としている。高い演算性能があっても、メモリ帯域が狭いとメモリと演算ユニット間のデータ転送でボトルネックになりうる。ベクトルエンジンを搭載するSX-Aurora TSUBASAは演算性能とメモリ帯域幅を両立することで効率的な計算を実現しているといえる。

現在のAIが発展している要因の一つには「計算リソースの充実」が挙げられる。AIの計算は基本的に複数のノード(ニューロン)を同時に更新するため、並列計算が得意なSX-Aurora TSUBASAはAI処理にも向いているというわけだ。

自然言語処理もSX-Aurora TSUBASAで高速に 非接触の接客や自動問診システムへ応用目指す

貨物積み込みの最適化でSX-Aurora TSUBASAの感触を得た樽井CTOが次に試したのは、同社のメイン技術である自然言語処理への適用だ。

自然言語処理は強化学習ほど並列計算が多く出てくるわけではない。また、バッチ的に一度に数時間かかる重い処理とは異なり、ウェルヴィルの開発する言語モデルはコンマ数秒で応答するリアルタイムのシステムだ。

そんなリアルタイムの言語処理システムを丸ごとSX-Aurora TSUBASAで実行したところ、AI的な処理ばかりではないにもかかわらず約8%の高速化を実現できたという。

「処理全体で8%の高速化なので、特に並列計算が多い意味解析の部分に効いているのだと思います」と樽井CTOは話す。

ウェルヴィルはSX-Aurora TSUBASAを活用して高速化した言語処理システムを、非接触の接客システムや事前問診システムなどに応用していきたい考えだ。

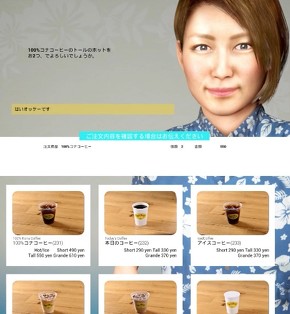

ウェルヴィルの業務向け対話エンジンを積んだ「AIアバターレジ」

ウェルヴィルの業務向け対話エンジンを積んだ「AIアバターレジ」同社は業務向けの対話エンジンを積んだ製品としては「AIアバターレジ」をリリースしている。これは画面上に映ったアバターが接客し、画面に商品を映しながら客の要望を聞くことで注文を受け付けるシステムだ。開発時期の関係から本製品はGPUで計算しているものの、今後業務向け対話エンジンを実装するに当たってはSX-Aurora TSUBASAを使っていくとしている。

ベクトルエンジンの有効な応用先は?

対話エンジンがメインの同社だが、東大とはさまざまなプロジェクトを共同研究している。中でも「汎用人工知能を作るプロジェクト」ではベクトル型に向いていると考える処理が多く出てくるため、SX-Aurora TSUBASAを使えば高速化できそうだと樽井CTOはみている。

「ここまで使ってみた感覚では、ど真ん中で有効なのはやはり強化学習ですね」と樽井CTO。具体的な適用先には貨物積み込みのような最適化計算や、自動運転などが挙げられるという。

もっとも、特に深層強化学習に関していえば人間を破った囲碁AI「AlphaGo」などにも使われている技術であることから、ポテンシャルは非常に高いといえる。どう使いこなすかは各企業や研究者のアイデア次第だろう。

SX-Aurora TSUBASA使いとしては“異端児” NEC「こんな例が出てくるのが共創の意義」

NECによれば、SX-Aurora TSUBASA Vector Engine(ベクトルエンジン)はすでに1万7000枚が売れており、さまざまな研究機関や大学施設、企業などに導入されているという。多くは、JAMSTECの地球シミュレータのように流体や気象などの数値シミュレーションに使われているため、いわば「重い処理の高速化」に役立てられている。

NECの浅田さん(AIプラットフォーム事業部マネージャー)

NECの浅田さん(AIプラットフォーム事業部マネージャー)そんな中、リアルタイムに応答する言語処理システムにVEを使ったウェルヴィルはある意味“異端児”といえる。

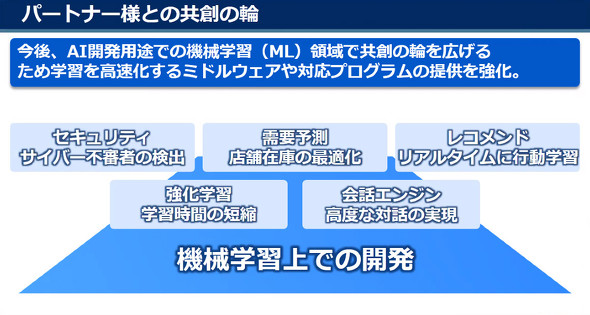

「われわれも想像していなかった、こんな応用例が出てくるのがまさにパートナーと共創する意義なのです」と、NECの浅田さん(AIプラットフォーム事業部マネージャー)は話す。

パートナーとの共創で、NECだけではできない領域もカバーしていく

パートナーとの共創で、NECだけではできない領域もカバーしていく樽井CTOはSX-Aurora TSUBASAを使う中でこんな要望も持ったという。「クラウドサービスでの提供はありませんか?」

「サービスによっては物理的に置く場所に制限もあります。ホスティングサービス、もしくはクラウドコンピューティングサービスなどが出てくると、さらに柔軟に使えそうです」(樽井CTO)

これについては「間もなくご提供できます」と浅田さん。現在パートナー企業とともにホスティングサービスを準備中だ。これも、SX-Aurora TSUBASA Vector Engine単体やエッジモデルなど、SX-Aurora TSUBASAを柔軟な形でパートナーに提供できるようになったからこその取り組みだ。

SX-Aurora TSUBASA Vector Engine単体の販売が20年11月に始まり、クラウドサービス開始も間近に迫るSX-Aurora TSUBASA。樽井CTOのような使い手の“異端児”は、これからどんどん増えそうだ。

「SX-Aurora TSUBASA」に関するアンケート実施中

現在「SX-Aurora TSUBASA」に関するアンケートを実施中です。

アンケートにお答え頂いた方から、抽選で10名様にAmazonギフト券3,000円分を差し上げます。

関連リンク

からの記事と詳細 ( AI処理で「100万円スパコン」使ってみた GPUからの移行は手間? 対話AIベンチャーが手応え明かす - ITmedia )

https://ift.tt/3b6v1ht

No comments:

Post a Comment